Как отличить настоящее видео от дипфейка: простые признаки ИИ-контента

ИИ все чаще подделывает видео (фото: Getty Images)

ИИ все чаще подделывает видео (фото: Getty Images)

Интернет-фейки больше не ограничиваются неудачным фотошопом - пользователей все чаще заполняют ИИ-видео и дипфейки, от поддельных реклам до фейковых "репортажей" о катастрофах. Современные технологии стирают грань между реальностью и вымыслом, делая подделки все более правдоподобными.

О том, на какие признаки стоит обратить внимание, чтобы распознать видео, созданное с помощью Sora, рассказывает РБК-Украина со ссылкой на CNET.

Что нужно знать о видео Sora

С технической точки зрения видео, созданные Sora, выглядят впечатляюще и превосходят решения конкурентов вроде Midjourney V1 и Google Veo 3. Они отличаются высоким разрешением, синхронизированным звуком и неожиданной креативностью. Одна из самых популярных функций - Cameo, позволяющая использовать внешность реальных людей и "вставлять" их практически в любую ИИ-сцену. Результат - пугающе реалистичные ролики.

Именно поэтому вокруг Sora так много опасений. Приложение существенно упрощает создание опасных дипфейков, распространение дезинформации и подмену реальности. Особенно уязвимы публичные личности и знаменитости - профсоюзы вроде SAG-AFTRA уже призвали OpenAI усилить защитные механизмы.

Если модель OpenAI Sora уже запутала информационное пространство, то ее вирусное продолжение - условная "социальная сеть" Sora 2 - стало одним из самых обсуждаемых и одновременно самых обманчивых феноменов в сети. По сути, это лента в стиле TikTok, где весь контент на 100% является фейковым. Платформа постоянно совершенствуется в создании реалистичных вымышленных сцен, что несет реальные риски для общества.

Как распознать видео, созданное с помощью Sora

Обратите внимание на водяной знак

Все видео, загруженные из iOS-приложения Sora, содержат водяной знак - белый логотип Sora в виде облака, который движется по краям кадра. Это похоже на водяные знаки TikTok и является одним из самых простых способов определить ИИ-контент.

Однако водяные знаки не дают стопроцентной защиты: статичные можно обрезать, а динамические - удалить с помощью специальных приложений. Глава OpenAI Сэм Альтман ранее заявил, что обществу придется адаптироваться к реальности, где любой может создать фейковое видео с кем угодно. Это означает, что одного визуального признака уже недостаточно.

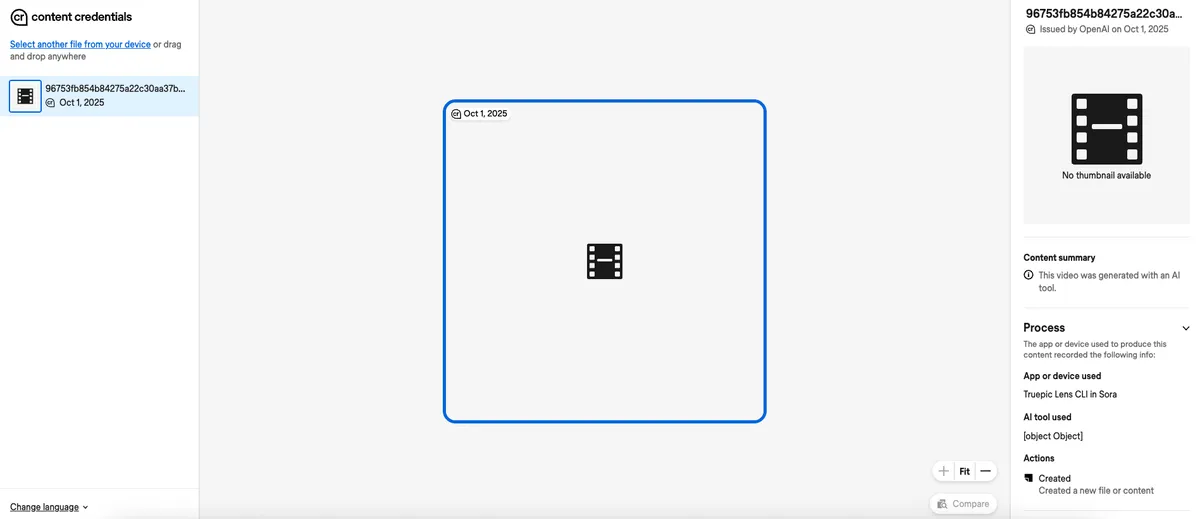

Проверьте метаданные

Хотя проверка метаданных может показаться сложной, на практике это один из самых надежных способов определить происхождение видео. Метаданные - это служебная информация, которая автоматически прикрепляется к файлу: тип камеры, дата и место съемки, имя файла и другие данные. У ИИ-контента часто присутствуют специальные метки, указывающие на его искусственное происхождение.

OpenAI входит в коалицию C2PA (Coalition for Content Provenance and Authenticity), поэтому видео Sora содержат соответствующие метаданные. Проверить их можно с помощью инструмента Content Authenticity Initiative (Инициатива по обеспечению подлинности контента).

Как проверить метаданные файла:

- Перейдите на сайт verify.contentauthenticity.org

- Загрузите фото, видео или документ

- Нажмите "Открыть"

- Изучите информацию в правой панели - если контент создан ИИ, это будет указано в описании.

При проверке видео Sora сервис указывает, что файл "выпущен OpenAI" и является ИИ-сгенерированным. Это позволяет подтвердить его происхождение.

Инструмент Content Authenticity Initiative (фото: CNET)

Инструмент Content Authenticity Initiative (фото: CNET)

Ограничения метода

Как и любые детекторы ИИ, этот инструмент не идеален. Видео, созданные другими сервисами, например Midjourney, могут не содержать нужных метаданных. Кроме того, если ролик Sora был обработан сторонним приложением и повторно сохранен, вероятность его корректного распознавания снижается.

Тем не менее, проверка метаданных остается одним из самых эффективных способов отличить реальное видео от дипфейка в эпоху стремительного развития ИИ.

Ищите маркировку ИИ и указывайте ее самостоятельно

В социальных сетях компании Meta - таких как Instagram и Facebook - пользователи могут получить дополнительную подсказку о том, является ли контент сгенерированным ИИ. У Meta есть внутренние системы, которые отмечают подобные материалы специальными метками. Эти механизмы не идеальны, но у помеченных публикаций можно увидеть соответствующую отметку. Аналогичные правила маркировки ИИ-контента действуют и на платформах TikTok и YouTube.

При этом единственный по-настоящему надежный способ понять, что контент создан искусственным интеллектом, - это прямое указание автора. Многие соцсети уже предлагают настройки, позволяющие помечать публикации как сгенерированные ИИ. Даже простое пояснение в подписи к посту помогает аудитории понять, каким образом был создан материал.

Пока пользователь листает ленту Sora, он понимает, что перед ним - вымысел. Однако после выхода за пределы приложения и публикации ИИ-видео на других платформах ответственность за раскрытие происхождения контента становится общей.

По мере того как такие модели, как Sora, все сильнее стирают грань между реальностью и вымышленным, именно пользователи должны делать максимально прозрачным происхождение видео - реальное оно или создано ИИ.

Главное - сохранять бдительность

Не существует универсального способа с первого взгляда точно определить, является ли видео реальным или сгенерированным ИИ. Лучшее, что можно сделать, - не верить безоговорочно всему, что вы видите в интернете. Если что-то кажется подозрительным или "неестественным", скорее всего, так оно и есть.

В условиях, когда сеть заполняется ИИ-контентом сомнительного качества, лучшая защита - внимательный просмотр. Стоит обращать внимание на искаженный текст, исчезающие объекты и движения, нарушающие законы физики. И если вы все же иногда попадаетесь на фейк - не стоит винить себя: даже эксперты не всегда могут распознать подделку.

Напомним, что крупные корпорации, такие как McDonald’s и Coca-Cola, снова оказались в центре скандала из-за реклманых роликов на основе ИИ.

Читайте также про главные технологические тренды 2025 года.

А еще мы писали, что эксперты проверили, способен ли искусственный интеллект обходить защиту и создавать вирусы.