Кібернетик Летичевський: Найбільша небезпека ШІ - це агітація за "руский мір"

Кібернетик Олександр Летичевський розповів про розвиток ШІ (колаж: РБК-Україна)

Кібернетик Олександр Летичевський розповів про розвиток ШІ (колаж: РБК-Україна)

Штучний інтелект стрімкими темпами розвивається по всьому світу - його уже застосовують для діагностики хвороб у медицині, складання економічних прогнозів і навіть синтезу нових речовин. ШІ не одноразово доказав, що здатний перевершити людський розум. Втім, такі результати багато кого насторожують і вже є чимало теорій про те, що технології візьмуть верх над людством.

Про те, яке майбутнє чекає ШІ, чи може він становити реальну загрозу людству, які розробки проводять в Україні та як новітні технології на основі ШІ можуть працювати проти нас у цій війні, розповів завідувач відділу теорії цифрових автоматів Інституту кібернетики імені В. Глушкова НАН України, доктор фізико-математичних наук Олександр Летичевський в інтерв'ю РБК-Україна (проект Styler).

– Людство досягло великого прогресу у розвитку ШІ. Зараз його уже застосовують практично у всіх сферах. Втім, поки ці технології ще не є досконалими. Яким ви бачите майбутнє ШІ?

– Визначмо, що таке штучний інтелект. Технологія нейронних мереж та технологія машинного навчання - це лише частина штучного інтелекту. Ще у 60-ті роки Віктор Глушков визначив, що ШІ це, насамперед, здатність виводити факти із знань, а не тільки машинне навчання на основі статистичних алгоритмів.

Наприклад, Chat GPT - навчається на фразах. ШІ не думає, він вибирає слова згідно з статистикою, але це дуже вдалий вибір. Ніякої семантики у виборі слів нема. Велика кількість навчання може дати результат, але оскільки нема семантики, то є ймовірність помилки.

У людини є дедуктивний спосіб сприйняття світу. Також вона навчається на якихось прикладах, емпіричних спостеріганнях, але вона визначає семантику знань, а технологія нейронних мереж - ні. Наприклад, коли дитині показати кицю, то вона на все життя її запам'ятає, тобто створить семантику, що це ніжна тварина на чотирьох лапах, яка мурчить. А машині треба тисячу киць показати, щоб вона навчилась їх впізнавати. І це велика різниця.

Chat GPT бере величезну кількість текстової інформації з інтернету, але ж вона там скоро закінчиться і далі заповнюватиметься текстами, згенерованими Chat GPT. Тоді чат стане насичуватись від самого себе і почнеться деградація цієї галузі - вона навчатиметься на своїх матеріалах.

Але разом із тим, машинне навчання та нейронній мережі - це дуже вдала розробка. Це винахід сторіччя. Його можна порівняти хіба з блокчейном (криптографічна база даних, яку закладено в основу Біткойна. - Ред).

Я бачу подальший розвиток штучного інтелекту виключно у поєднанні нейронних мереж і дедуктивного мислення.

Завідувач відділу теорії цифрових автоматів Інституту кібернетики імені В. Глушкова НАН України Олександр Летичевський (фото: visnyk-nanu.org.ua)

– В Україні зараз ведуться якісь розробки на основі ШІ? Чим ви займаєтесь?

– Ми працюємо в області кібербезпеки. Штучний інтелект допомагає нам розрізняти атаки на комп’ютер, мережеве середовище. Тобто, ми вивчаємо трафік попередніх атак, тренуємо нейронну мережу і вже можемо визначити, що це за атака. Ця розробка дає непогані результати. Але хакери постійно придумують нові атаки, з цим важко боротися.

Також хакери можуть маскуватись під нормальний трафік, таке ще важко розрізняти. Поки ми ще не подолали цю проблему, але вже використовуємо комбінацію нейронних мереж і дедуктивного виявлення, бо лише нейронної мережі недостатньо.

Ще вивчаємо використання нейронної мережі в наукових експериментах. Зокрема, у хімії, фізиці. Тут це доречно. Наприклад, якщо потрібно синтезувати якусь речовину із певними властивостями, то є величезна кількість варіантів, як її можна отримати. Таких комбінацій може бути нескінченна кількість. І тут допоможуть методи штучного інтелекту - вони підказують напрям пошуку на досвіді попередніх даних. Це цінне використання.

Також ми проводимо дослідження, за допомогою яких нейромережа може показати, як людська клітина реагуватиме на певні ферменти при лікуванні раку. З цією технологією можна отримувати найкращий сценарій, який приведе до того, що пухлинна клітина загине.

– Які професії зникнуть через стрімкий розвиток ШІ, бо не буде потреби у людському ресурсі?

– Згадаймо всю історію людства - професії постійно зникають. От, наприклад, мультиплікація. Зараз з'явились автоматизовані програми, які чудово створюють картинки і це вже не Діснеївська мультиплікація, яку колись малювали роками. А ті люди, що раніше малювали пензлем, тепер перекваліфікувались, як користувачі цих програм.

Я не вірю, що зникнуть програмісти, бо писати програму на базі технології, що використовує лише статистичні методи, на основі яких будуються нейронні мережі - це джерело помилок та неточностей. Я б не пішов у таку ІТ-компанію щось замовляти.

У професіях, які пов'язані з аналітикою, де треба вивчати величезну кількість літератури і робити висновки, ШІ дуже помічний. Наприклад, у юриста є якась ситуація і для того, щоб знайти вердикт, чи пояснення, спеціалісти можуть тижнями працювати. А Chat GPT, який налаштований на юридичну тему, видасть вам результат за секунди.

Тому, дійсно, зникнуть певні професії, але нічого страшного у тому немає. На базі штучного інтелекту будуть вже нові професії, які доведеться опановувати людині.

Олександр Летичевський розповів про українські розробки на основі ШІ (фото надане О. Летичевським)

Олександр Летичевський розповів про українські розробки на основі ШІ (фото надане О. Летичевським)

– У яких сферах не варто використовувати ШІ і чому?

– Штучний інтелект можна використовувати повсюди, але він не має бути останньою інстанцією, особливо у критичних сферах, таких як медицина, військова справа, кібербезпека. Тобто там, де ми не маємо права на помилку.

У медицині, наприклад, ШІ аналізує рентгенівські знімки і визначає наявність хвороби. Але це не має бути останнім висновком. Ще має бути слово лікаря, який діє згідно з протоколом. ШІ може бути тільки як підказка. Але про заборону ШІ в медицині - мова не йде, бо він може дійсно на щось вказати, що не помітив лікар. Тому в критичних сферах, де треба приймати рішення, від якого залежить життя людей, повністю довіряти ШІ не можна.

– А чи доречно застосовувати ШІ в освітній сфері? Якщо школярі та студенти писатимуть контрольні чи курсові з його допомогою, то чи не призведе це до отупіння молоді?

– У Британських університетах при написанні робіт дозволяють використовувати Chat GPT тільки як довідник, але його не можна використовувати в студентських роботах. Вже є програми, які визначають, цей текст написала людина чи Chat GPT. Ці технології можна використовувати як підказку, бо чат обробляє велику кількість знань і з цього можна робити висновки, які будуть корисні. Їх треба використовувати лише свідомо, аналізуючи коректність.

Школярам можна дозволити тільки вивчати щось на основі ШІ, а робити контрольні вони мають самі.

– Які ви вбачаєте небезпеки у розвитку ШІ?

– Вже зараз ведуться розмови про те, що системи ШІ треба ліцензувати так само як ліки чи атракціони. Вони мають бути безпечними для того, щоб їх використовували у різних галузях.

Є певна небезпека для демократії. З чат-ботами можна створити багато акаунтів у соцмережах і вони агітуватимуть людей за певні політичні партії або підбурюватимуть до неправомірних дій. Люди ж дуже емоційно сперечаються, ображають одне одного, а от чат-бот толерантний, він акуратно нав'язуватиме свою думку. А це вже напад на демократію. Це серйозна штука. Тому це треба відстежувати і все сертифікувати, бо це вплив на загальну свідомість у соцмережах.

– Тобто таки треба обмежувати розвиток штучного інтелекту?

– Треба контролювати такі продукти і сертифікувати. Chat GPT не є небезпечним, але люди починають йому уже довіряти, але там є такі явища, як галюцинації - вигадані факти і події. Якось я його запитав, чи знає він про мою статтю про слонів, а він почав про неї щось розказувати, хоч у мене ніколи не було такої статті...

Ми не можемо перешкодити розвитку ШІ. Люди робитимуть нові винаходи на його основі. Це все кількісно перейде у якість і буде дійсно впливати на всі сфери нашої діяльності.

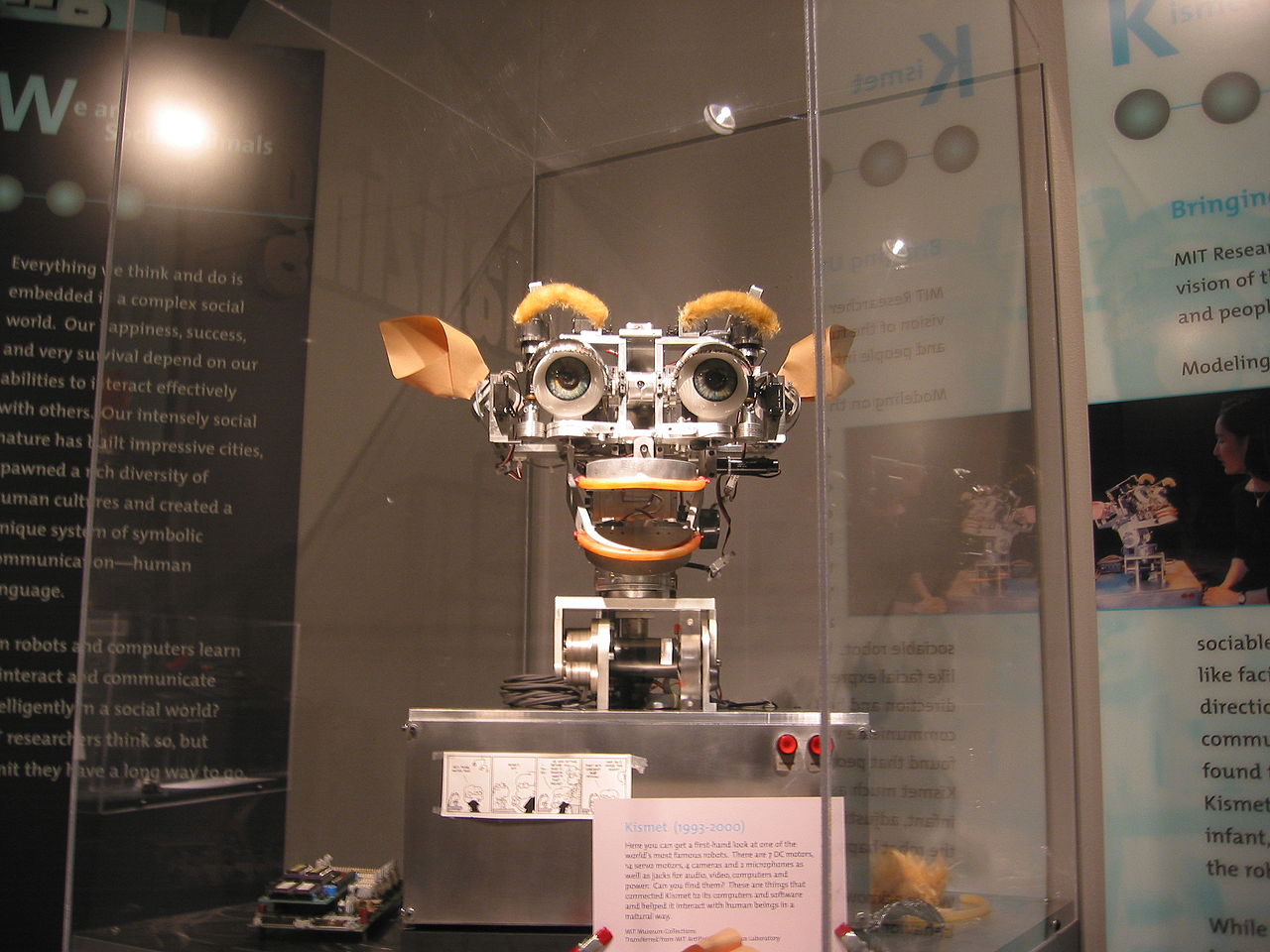

Kismet - робот з базовими соціальними навичками, який створили у кінці 90-х років у Массачусетському технологічному інституті (фото: Вікіпедія)

Kismet - робот з базовими соціальними навичками, який створили у кінці 90-х років у Массачусетському технологічному інституті (фото: Вікіпедія)

– Є чимало теорій про те, що ШІ зможе настільки розвинутись, що знищить людство. Наскільки реальні такі загрози?

– Людство можна буде цивілізаційно знищити, якщо ШІ активно братиме участь у соцмережах і впливатиме на пересічних користувачів. На яку ступінь ми йому дозволимо втручатися у життя людства, так це і буде. Бо якщо ми йому дозволимо запускати ракети і давати такі рішення на основі штучного інтелекту, тоді звичайно - це небезпека.

Але розмови про те, що з'являться якісь фантастичні роботи, які будуть все знищувати - до цього ще далеко. Хоча вже є випадок, коли одного разу робот на складі помилково сприйняв людину за товар і розчавив її своїм маніпулятором.

Тому, це все не повинно контролюватись виключно нейронними мережами. Якщо хтось це дозволить в критичних сферах, то це буде злочин.

– Чи були ще випадки, коли застосування ШІ нашкодило людям?

– Нейронні мережі, які погано натреновані, роблять помилки і, звичайно, що вони будуть, бо технологія ще вдосконалюється. Але більше фатальних випадків не пригадую.

– Як може штучний інтелект працювати проти України у війні? От нещодавно за допомогою новітніх технологій росіяни створили реалістичне фейкове відео, на якому начебто Залужний говорить, що йде проти Зеленського...

– Так, зараз дійсно можна створювати такі фейки та імітувати чужі голоси. Але є вже програми, які можуть розрізняти, чи це, наприклад, справжній голос Залужного, чи ні. Програми також визначають фейки і по інформації, бо чат-бот це специфічна машина, яка певним чином формулює фрази і ці характерні риси чату можна виявити таким же штучним інтелектом, як і він.

Але найбільша небезпека - це агітація за "руский мір", яка може бути у соцмережах. Можна перелаштувати і навчити Chat GPT, бо це ж доступна технологія. І це дуже небезпечно.

Фото, згенероване ШІ, яке масово поширили в інтернеті у січні 2023 року. Його опублікували для ілюстрації наслідків атаки росіян по житловому будинку в Дніпрі. Цей "знімок" похитнув довіру до українців зі сторони іноземців, оскільки він підіграв російським наративам про те, що "трагедії у нас є постановочними, а не справжніми" (фото: із вільного доступу)

Фото, згенероване ШІ, яке масово поширили в інтернеті у січні 2023 року. Його опублікували для ілюстрації наслідків атаки росіян по житловому будинку в Дніпрі. Цей "знімок" похитнув довіру до українців зі сторони іноземців, оскільки він підіграв російським наративам про те, що "трагедії у нас є постановочними, а не справжніми" (фото: із вільного доступу)

– Де доцільно застосовувати ШІ в Україні?

– Як я вже казав, у медицині. У нашому інституті є гарні розробки, які дозволяють аналізувати рентгенівські знімки хворих. Також у криміналістиці, коли поліції треба розрізнити обличчя на відео. В економіці можна моделювати і передбачати певні сценарії. У наукових дослідженнях доцільно застосовувати ШІ.

Чи треба застосовувати ШІ у творчості - спірне питання. Якщо писати твори, то це вже справа смаку, хіба якщо навчити індивідуального стилю. Чи матиме вони якусь цінність, то тут хай вже вирішують спеціалісти по літературі. Колись я із задоволенням читав твори машини, які були створенні ще у 80-тих роках. Вони були дуже близькі до людських.

Якщо говорити про мистецтво, то ШІ може створити неймовірні картини, але це неусвідомлена творчість, під нею нічого немає. Ніякого вкладення душі, якоїсь людської риси - це все статистичні методи. Як ШІ навчили, так він на основі того і генерує. Нічого нового він не створює, але ці картини можуть бути дуже ефектні.

Якщо ми навчимо музики нейронну мережу, то вона генеруватиме мелодії на основі тих, що їй показали. Але Бахів і Бетховенів ми від неї не отримаємо.

– Чи можемо в Україні створити щось на зразок Кремнієвої долини?

– В Україні одні із найкращих розробників програмного забезпечення. Ви подивіться, зараз у хакатонах (форум розробників програмного забезпечення - Ред.) перемагають вихідці з України. Тому думаю, що все ще буде. На жаль, зараз складна ситуація. Але у нас можна і треба будувати Кремнієву долину. Ми маємо дуже серйозну школу програмування.

У 80-ті роки Інститут кібернетики був молодіжним закладом. Це була своя Кремнієва долина з величезною кількістю напрямів та систем. У того ж Віктора Глушкова було багато розробок, які так і не дійшли до впровадження. У нас тут була перша у світі персоналка, інтернет, автоматичне доведення теорем і ще багато чого створено. У нас може таке бути і в майбутньому, якщо дати відповідні умови.

Раніше ми робили велике інтерв'ю із астрономом Іваном Крячком із головної обсерваторії НАН України про дослідження космосу, колонізацію Місяця та Марса і роль українців у цих дослідженнях.

Читайте також наше велике інтерв'ю з академіком НАН України Яковом Дідухом про відновлення екосистем на місці Каховського водосховища, Чорнобиль та зміни клімату в Україну.